Du möchtest deine virtuelle Maschine von der Hetzner Cloud auf deinen eigenen Proxmox Server migrieren? Diese ausführliche Anleitung zeigt dir, wie du eine 1:1 Migration durchführst – ohne Datenverlust und mit minimaler Downtime.

Warum von Hetzner Cloud zu Proxmox wechseln?

Die Migration von Hetzner Cloud zu einem eigenen Proxmox Server bietet mehrere Vorteile:

- Kosteneinsparung: Langfristig günstiger als Cloud-Hosting

- Vollständige Kontrolle: Eigene Hardware und Konfiguration

- Bessere Performance: Dedizierte Ressourcen ohne Sharing

- Datenschutz: Deine Daten bleiben auf eigener Hardware

Voraussetzungen für die Migration

Bevor du beginnst, stelle sicher, dass du folgende Komponenten bereit hast:

- Funktionierenden Proxmox Server

- Hetzner Storage Box oder ausreichend Speicherplatz

- SSH-Zugang zu beiden Systemen

- Backup deiner wichtigen Daten (Sicherheit geht vor!)

Schritt 1: Hetzner Cloud Instanz vorbereiten

Zuerst musst du deine VM ordnungsgemäß herunterfahren, um Dateninkonsistenzen zu vermeiden.

# VM sauber herunterfahren (vor dem Rescue-Modus)

sudo shutdown -h now

Wichtig: Starte anschließend das Rescue-System über die Hetzner Cloud Console. Dies gibt dir vollständigen Zugriff auf die VM-Hardware.

Schritt 2: Festplatte im Hetzner Rescue System klonen

Storage Box mounten

# Verzeichnis für Storage Box erstellen

mkdir -p /mnt/storagebox

# Mount über SMB/CIFS (ersetze username und password)

mount -t cifs //username.your-storagebox.de/backup /mnt/storagebox -o username=username,password=yourpassword

# SSH-Schlüssel-basierte Verbindung (Alternative)

# mkdir -p ~/.ssh

# echo "your-storage-box-ssh-key" >> ~/.ssh/authorized_keys

# sshfs username@username.your-storagebox.de:/ /mnt/storagebox

Festplatte identifizieren und sichern

# Verfügbare Festplatten anzeigen

lsblk

fdisk -l

# Festplatte klonen mit Kompression (spart Zeit und Speicher)

# WICHTIG: /dev/sda durch die korrekte Festplatte ersetzen

dd if=/dev/sda bs=64M status=progress | gzip > /mnt/storagebox/hetzner-vm-backup.img.gz

Pro-Tipp: Die Kompression mit gzip reduziert die Dateigröße erheblich und beschleunigt die Übertragung.

Schritt 3: Image auf Proxmox Server übertragen

Storage Box auf Proxmox mounten

# Storage Box auf Proxmox Server mounten

mkdir -p /mnt/storagebox

mount -t cifs //username.your-storagebox.de/backup /mnt/storagebox -o username=username,password=yourpassword

# Komprimiertes Image entpacken und lokal speichern

gunzip -c /mnt/storagebox/hetzner-vm-backup.img.gz > /var/lib/vz/images/hetzner-vm-backup.img

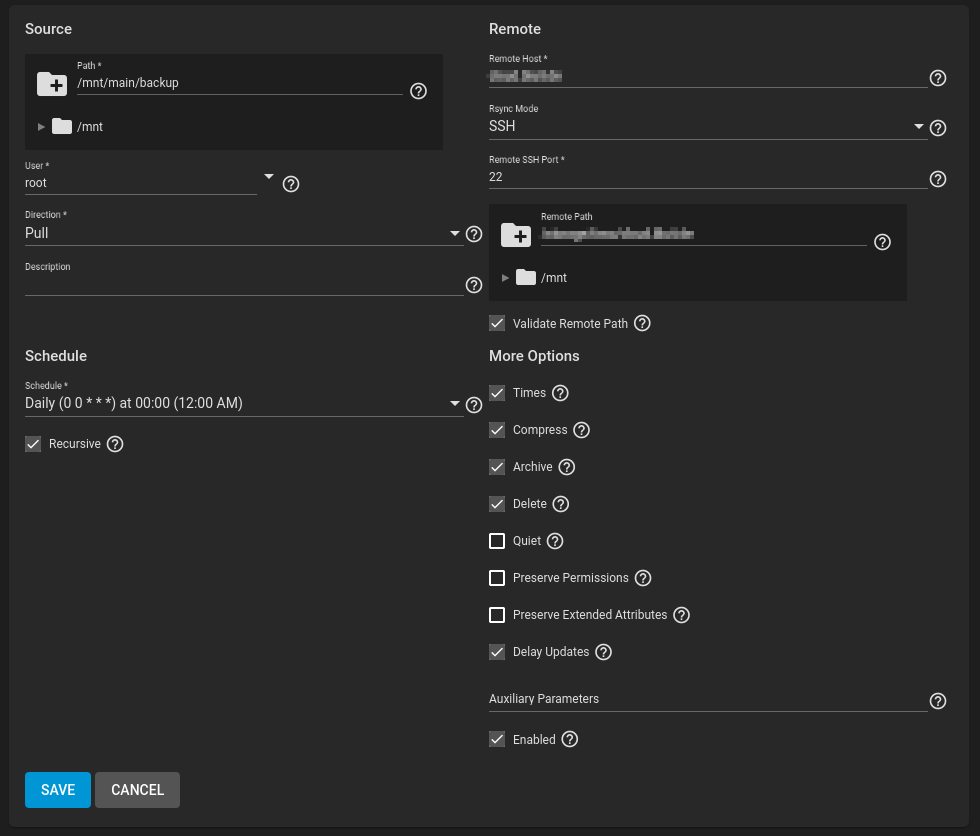

Virtuelle Maschine in Proxmox erstellen

# VM mit passenden Spezifikationen erstellen

qm create 100 \

--name migrated-vm \

--memory 2048 \

--cores 2 \

--net0 virtio,bridge=vmbr0 \

--ostype l26 \

--cpu host \

--bios seabios

# Disk-Image importieren

qm importdisk 100 /var/lib/vz/images/hetzner-vm-backup.img local-lvm

# Importierte Festplatte zur VM hinzufügen

qm set 100 --scsi0 local-lvm:vm-100-disk-0

# Boot-Konfiguration setzen

qm set 100 --boot c --bootdisk scsi0

Wichtig: Passe RAM, CPU-Kerne und Netzwerk-Bridge entsprechend deiner ursprünglichen VM-Konfiguration an.

Schritt 4: Erste Konfiguration nach dem Boot

VM starten und Zugang herstellen

Starte nun die VM über die Proxmox Web-Konsole. Der erste Boot kann länger dauern, da das System die neue Hardware erkennt.

Hinweis: Standardmäßig ist eine englische Tastatur konfiguriert!

Deutsches Tastaturlayout aktivieren

# Sofortige Umstellung auf deutsches Layout

sudo loadkeys de

# Permanente Konfiguration

sudo dpkg-reconfigure keyboard-configuration

# Wähle: Generic 105-key PC → German → German

# Alternative: Über localectl

sudo localectl set-keymap de

Schritt 5: Cloud-Init deaktivieren

Cloud-Init kann in der Proxmox-Umgebung Probleme verursachen und sollte deaktiviert werden:

# Cloud-Init Services deaktivieren

sudo systemctl disable cloud-init

sudo systemctl disable cloud-init-local

sudo systemctl disable cloud-config

sudo systemctl disable cloud-final

# Cloud-Init Netzwerk-Konfiguration dauerhaft deaktivieren

sudo mkdir -p /etc/cloud/cloud.cfg.d/

echo 'network: {config: disabled}' | sudo tee /etc/cloud/cloud.cfg.d/99-disable-network-config.cfg

# Cloud-Init komplett deaktivieren

sudo touch /etc/cloud/cloud-init.disabled

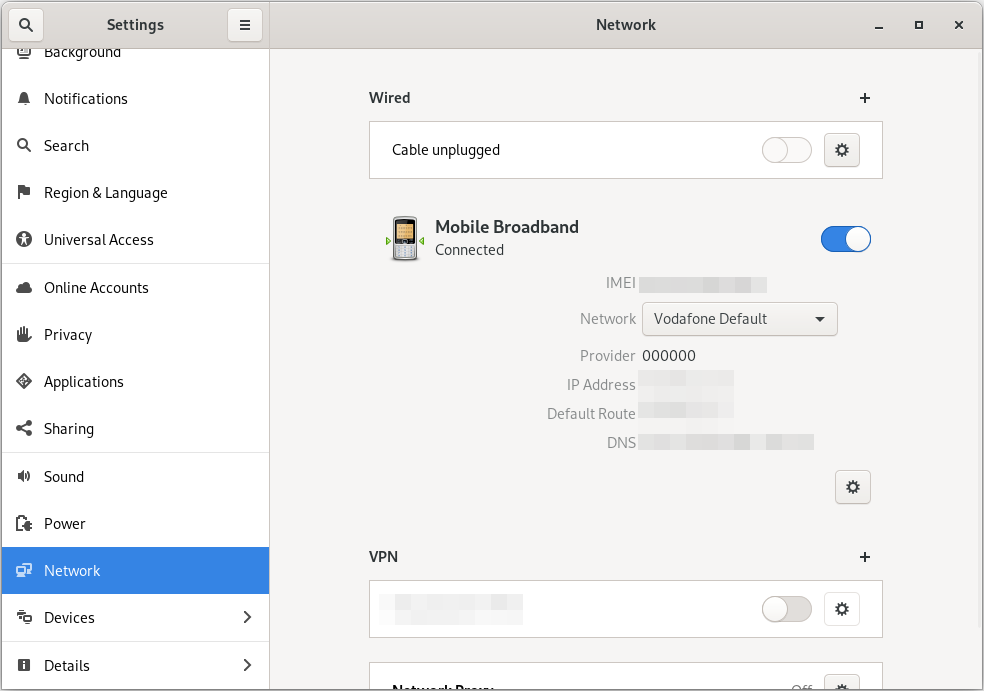

Schritt 6: Netzwerk-Konfiguration korrigieren

Das größte Problem nach der Migration ist meist die Netzwerk-Konfiguration. Hetzner Cloud und Proxmox verwenden unterschiedliche Interface-Namen und Konfigurationsmethoden.

Konkurrierende Netzwerk-Systeme identifizieren

# Aktive Netzwerk-Services prüfen

systemctl status networking

systemctl status systemd-networkd

systemctl status NetworkManager

Lösung: Netplan verwenden (empfohlen für Ubuntu 18.04+)

# Classic networking deaktivieren

sudo systemctl disable networking

# Alte Cloud-Init Netplan-Konfigurationen entfernen

sudo rm -f /etc/netplan/50-cloud-init.yaml

sudo rm -f /etc/netplan/*cloud*

# Neue Netplan-Konfiguration erstellen

sudo nano /etc/netplan/01-netcfg.yaml

Moderne Netplan-Konfiguration (für statische IP):

network:

version: 2

renderer: networkd

ethernets:

ens18: # Interface-Name kann variieren (ens18, eth0, enp0s18)

addresses:

- 192.168.1.100/24 # Deine gewünschte IP-Adresse

routes:

- to: default

via: 192.168.1.1 # Dein Gateway

nameservers:

addresses:

- 192.168.1.1 # Dein DNS-Server

- 8.8.8.8 # Backup-DNS

dhcp4: false

dhcp6: false

Für DHCP-Konfiguration:

network:

version: 2

renderer: networkd

ethernets:

ens18:

dhcp4: true

dhcp6: false

Konfiguration anwenden und testen

# Netplan-Konfiguration anwenden

sudo netplan apply

# Netzwerk-Status prüfen

ip a

ip route

# Verbindung testen

ping 8.8.8.8

ping google.com

# Persistenz durch Neustart testen

sudo reboot

Schritt 7: System-Optimierung nach der Migration

SSH-Host-Keys erneuern

Aus Sicherheitsgründen solltest du neue SSH-Host-Keys generieren:

# Alte SSH-Host-Keys entfernen

sudo rm /etc/ssh/ssh_host_*

# Neue Keys generieren

sudo dpkg-reconfigure openssh-server

# SSH-Service neustarten

sudo systemctl restart ssh

System-Updates durchführen

# Package-Listen aktualisieren

sudo apt update

# System vollständig aktualisieren

sudo apt upgrade -y

# Nicht benötigte Pakete entfernen

sudo apt autoremove -y

# System neustarten

sudo reboot

System-Status überprüfen

# Failed Services anzeigen

sudo systemctl --failed

# System-Informationen anzeigen

hostnamectl

free -h

df -h

lsblk

# Hardware-Erkennung prüfen

dmesg | grep -i error

sudo journalctl -b | grep -i error

Häufige Probleme und Lösungen

Problem: VM bootet nicht oder bleibt hängen

Lösung: Hardware-Kompatibilität anpassen

# VM stoppen

qm stop 100

# CPU-Typ auf 'host' setzen

qm set 100 --cpu host

# BIOS statt UEFI verwenden

qm set 100 --bios seabios

# IDE statt SCSI-Controller (bessere Kompatibilität)

qm set 100 --ide0 local-lvm:vm-100-disk-0

qm set 100 --boot order=ide0

# Serial Console für besseres Debugging

qm set 100 --serial0 socket

Problem: Netzwerk funktioniert nicht dauerhaft

Ursache: Mehrere Netzwerk-Management-Systeme konkurrieren

Lösung:

- Cloud-Init komplett deaktivieren

- Nur ein Netzwerk-System verwenden (Netplan ODER interfaces)

- Korrekte Interface-Namen verwenden

Problem: Interface-Name unbekannt

# Alle verfügbaren Interfaces anzeigen

ip link show

ls /sys/class/net/

# Typische Namen:

# - ens18 (moderne Ubuntu-Versionen)

# - eth0 (ältere Versionen)

# - enp0s18 (bestimmte Konfigurationen)

Fazit

Die Migration einer VM von Hetzner Cloud zu Proxmox ist durchaus machbar und bietet langfristig viele Vorteile. Die kritischen Schritte sind:

- Saubere Vorbereitung: VM ordnungsgemäß herunterfahren

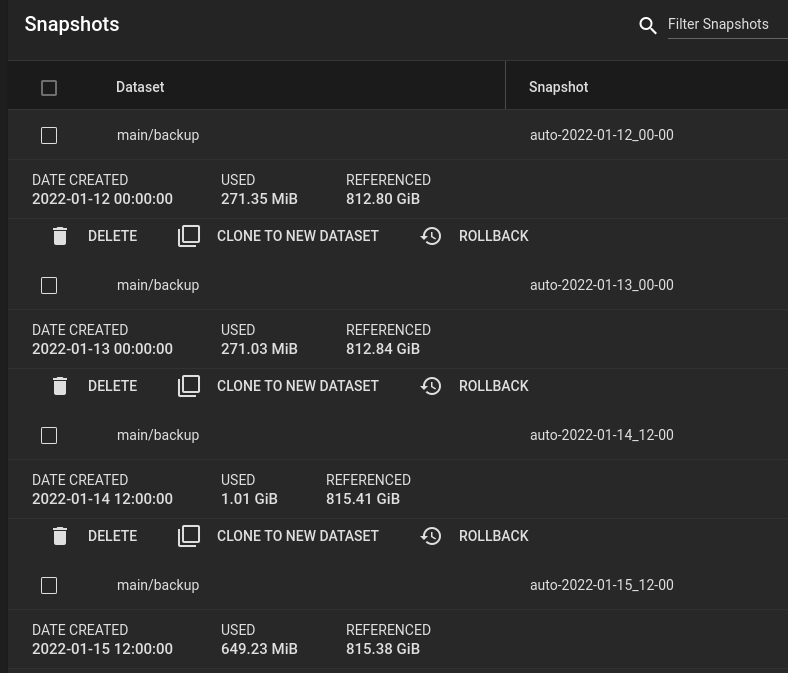

- Vollständiges Backup: 1:1 Kopie der Festplatte erstellen

- Korrekte Hardware-Konfiguration: CPU, RAM und Storage anpassen

- Netzwerk-Bereinigung: Cloud-Init deaktivieren und Netplan konfigurieren

- System-Optimierung: Updates und Sicherheits-Anpassungen

Mit dieser Anleitung solltest du deine VM erfolgreich migrieren können. Bei Problemen ist es wichtig, die Logs zu analysieren und systematisch vorzugehen.

Hast du Fragen zur Migration oder sind Probleme aufgetreten? Teile deine Erfahrungen in den Kommentaren!